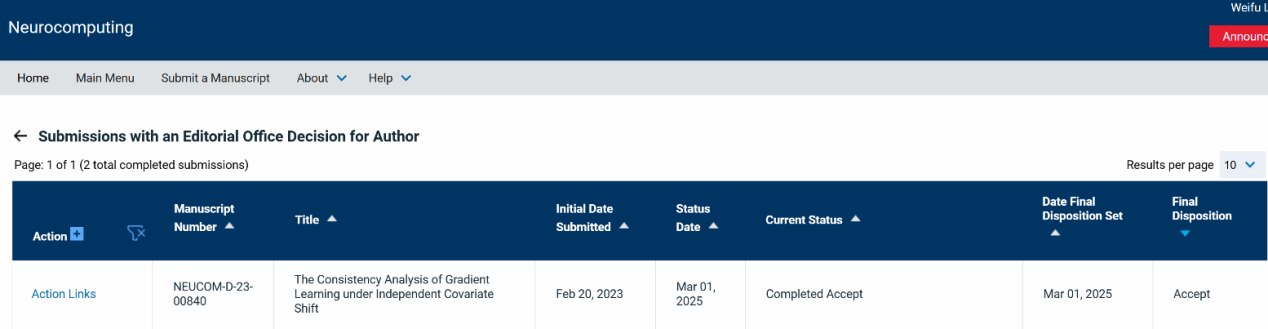

[作者-刘力源|审核-刘心月]2025年3月2日,我组题为“The Consistency Analysis of Gradient Learning under Independent Covariate Shift”的论文被人工智能期刊Neurocomputing录用。

在统计学和机器学习领域,由于对计算可行性和结果可解释性的需求,与高维数据相关的变量选择问题受到了广泛关注。梯度学习,基于泰勒展开和再生核Hilbert空间的性质,作为一种高度灵活的学习范式,通常具有严格的逼近理论基础,并在回归、分类和变量选择等任务中展现出了良好的性能。然而,目前对梯度学习的理论分析均基于样本独立同分布的假设。因此,本文针对独立协变量偏移情况下的梯度学习模型提供了理论保证。从函数近似的角度,建立了泛化误差的上界,并在密度比有界的条件下,证明了其一致收敛性。

博士生刘力源为论文第一作者,李伟夫副教授为通讯作者,陈洪教授、海南大学肖驰副教授参与了该研究工作。该项工作得到了国家自然科学基金的资助。